-

Notifications

You must be signed in to change notification settings - Fork 0

New issue

Have a question about this project? Sign up for a free GitHub account to open an issue and contact its maintainers and the community.

By clicking “Sign up for GitHub”, you agree to our terms of service and privacy statement. We’ll occasionally send you account related emails.

Already on GitHub? Sign in to your account

[9주차] 컴퓨터 비전 학습 경진대회 #9

Comments

where함수는 조건문을 사용할 수 있다. 조건에 만족하는 특정 값들을 찾아 원하는 숫자로 바꿀 수 있다.

train_generator = idg.flow(x_train,y_train, batch_size = 1)

#data와 label 배열을 가지고 온다. batch size만큼 data를 증가시킨다.

|

tf.keras.layers.experimental.preprocessing

|

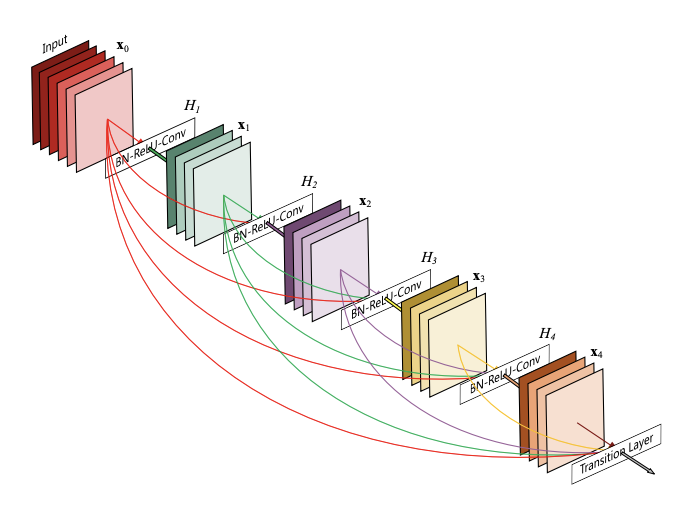

DenseNetDensely Connected Convolutional Networks 최근 연구에 따르면 convolutional networks가 입력에 가까운 레이어와 출력에 가까운 레이어 사이의 짧은 연결을 포함할 경우 훨씬 더 깊고 정확하게 효율적으로 훈련할 수 있다는 것을 보여주었다. 레이어가 L개 있는 기존의 convolutional networks에는 각 레이어와 후속 레이어 사이에 하나씩 L 연결이있는 반면, 우리 네트워크에는 L (L + 1) / 2 직접 연결을 가진다. vanishing-gradient problem을 완화, feature propagation 강화, feature reuse 장려, parameter 수 상당히 줄인다.

Bottleneck차원을 줄였다가 뒤에서 차원을 늘린다. --> 연산 시간을 줄이기 위해 |

글자에 숨겨진 숫자 이미지 예측

https://dacon.io/competitions/official/235626/overview/

The text was updated successfully, but these errors were encountered: